L

June 03, 2023

本文旨在按字母顺序对团队研究过程中涉及的术语进行分类解释,为对该领域感兴趣的读者提供一份全面的术语表。

Label

在监督学习(Supervised Learning)中,标签(Label)指的是与训练数据成对出现的“答案”。对于图像训练数据,标签(Label)就是真实的目标值(ground truth)。 例如,对于房屋数据的特征(Feature)可以是卧室数量、浴室数量和房屋年龄, 而标签(Label)可以是房屋的价格。对于垃圾邮件检测数据,特征(Feature)可以是邮件主题、发件人和邮件内容,而标签(Label)可以是“垃圾邮件”或“非垃圾邮件”。

LASSO Regression

LASSO(Least Absolute Shrinkage Selector Operator)是一种选择重要变量并将其他系数收缩至零的方法。这一特点被称为特征选择,与岭回归有所不同。由于使用了L1正则化,LASSO也被称为L1正则化器(L1 regularizer)。

Layer

神经网络(Neural Network)是一组处理输入和输出的神经元集合。通常被称为层(Layer),一般情况下,随着层数的增加(深度),网络能够表示的信息量也变得更加丰富。

Learning rate

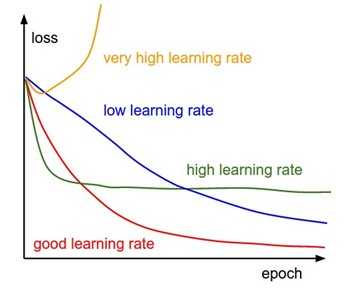

学习率(Learning rate),也称为学习速率,与步长(step size)具有相同的含义,但更多地从速度的角度来表示。 在下图中,我们可以看到在训练过程中学习率的重要性。较高的学习率会导致损失函数呈指�数衰减,而较低的学习率则会呈线性衰减。尽管高学习率可以更快地找到较低的损失值,但有时也可能陷入更差的损失值中。

Likelihood

似然度(Likelihood)是指概率分布的参数与某个随机变量的采样值一致程度。假设随机变量 X 服从参数为 θ 的概率分布 P_θ(X),当 X 被采样为 x 时,θ 的似然度定义如下:

这个”Likelihood”的概念是在贝叶斯定理中用于计算后验概率的。

Linear Regression

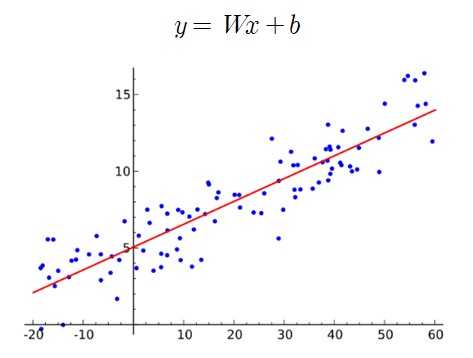

利用线性函数对数据进行回归的技术是机器学习中最基本的方法之一。简单地说,当在二维坐标上散布的数据点的分布被认为是线性的时候,可以通过线性函数进行近似预测。然而,如果数据不是线性分布的,那么预测准确率就会下降。

Localization

++ Need to Fill ++

Logistic Regression

通过应用逻辑斯蒂(Logistic)或S形函数(Sigmoid)对线性预测进行转换,可以生成关于离散值的概率,这是一种分类技术。逻辑回归(Logistic Regression)主要用于二元分类(Binary Classification)问题。

Long-tail distribution

++Need to Fill++

Loss Function

损失函数(Loss function)通常针对数据点、预测值和标签进行定义,并计算类似误差的惩罚。虽然成本函数经常与之相比较,但严格来说,损失函数是一个稍微更加狭窄的概念。 简单地说,对于单个训练样本,可以将其视为损失函数,而对于整个训练样本集,可以将其视为成本函数。

LSTM

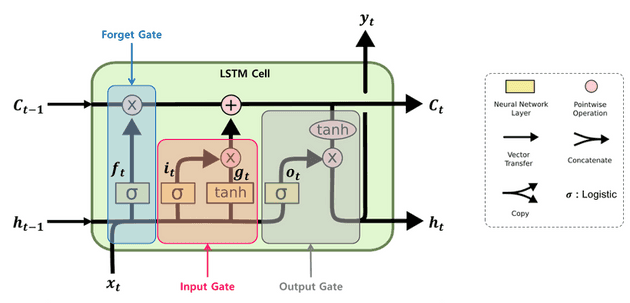

LSTM(长短时记忆网络)是为了解决RNN中梯度消失问题(即在相关信息和使用该信息的位置之间距离较远时,反向传播中的梯度逐渐减小,导致学习能力严重下降)而设计的。 LSTM在传统RNN的基础上增加了细胞状态(cell state)到隐藏状态(hidden state)的连接,内部由遗忘门(forget gate)、输入门(input gate)和输出门(output gate)组成。 遗忘门决定了要忘记多少过去的信息,输入门决定了要记住多少当前的信息,而输出门将这两者结合并输出。