G

June 03, 2023

本文旨在按字母顺序对团队研究过程中涉及的术语进行分类解释,为对该领域感兴趣的读者提供一份全面的术语表。

Generalization

在测试模型性能时,不是在训练过程中产生的错误,而是在测试过程中产生的错误被称为泛化误差(Generalization Error)。 在评估模型性能时,我们使用与训练数据不同的未见数据(unseen data)进行测试,因为训练数据和测试数据之间没有交集,所以将测试称为泛化(Generalization),测试误差被称为泛化误差。 当模型复杂度(Complexity)和数据表示信息的规模不匹配时,就会发生过拟合/欠拟合(Overfitting/Underfitting),这被称为不良泛化(Bad Generalization)。

Generative Model

生成模型(Generative Model)定义了数据()生成的过程,其中包括两个概率模型()和(),通过贝叶斯规则间接推导出()。生成模型可以建立有或没有标签信息的模型。 前者称为基于监督学习的生成模型,其中线性判别分析(Linear Discriminant Analysis: LDA)是一个典型的例子。LDA通过学习数据分布并创建决策边界来对数据进行分类。 后者称为基于无监督学习的生成模型,其中高斯混合模型和主题建模(Topic Modeling)是典型的例子。主题建模中的一种技术是潜在狄利克雷分配(Latent Dirichlet Allocation),它是一个关于给定文档中存在哪些主题的概率模型。 生成模型相对于判别模型有更多的假设,如果这些假设与实际现象不匹配,生成模型的性能可能不如判别模型。反之,如果假设构建得很好,它可以对异常值具有鲁棒性,并且在数据量不足的情况下也可以展现出良好的预测性能。 生成模型的目标是学习类别的分布。此外,与一般的贝叶斯推断相似,随着训练数据的增多,生成模型往往会收敛到与判别模型相似的性能水平。此外,由于生成模型构建了(),因此可以利用该模型对()进行采样。

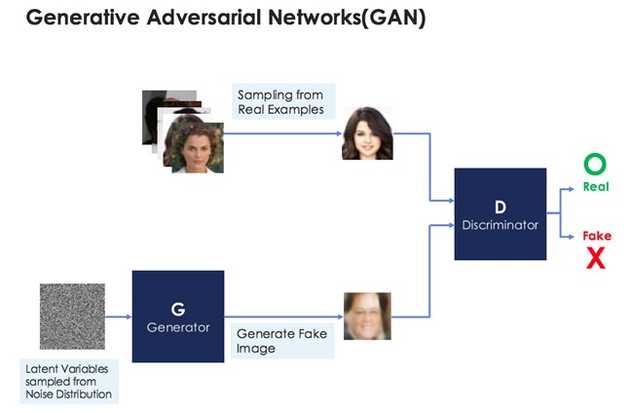

Generative Adversarial Networks(GAN)

基本的架构由鉴别器(Discriminator)和生成器(Generator)组成。这可以类比为警察和伪造货币制造者之间的关系。鉴别器通过学习区分真实图像和生成器生成的假图像,而生成器经过训练以产生能够欺骗鉴别器的图像, 这些图像是从潜在变量(从噪声分布中抽取的值)中生成的。结果是,生成器能够几乎精确地逼近真实数据的分布,而鉴别器则达到了以50%的概率区分真实图像和假图像(生成器生成的)的平衡点。 我们无法确定生成器学习的是什么,但可以理解为学习了某种关于目标的表示。 通过使用经过训练的生成器,我们可以生成新的图像,因此将这种模型称为生成模型(Generative Model),而其中的一系列训练过程被称为对抗学习(Adversarial Learning)。当然,这不仅适用于图像,还适用于文本、语音等其他类型的数据。

生成对抗网络(GAN)的架构

Gradient Descent

梯度下降法(Gradient Descent)是一种根据训练数据条件来计算模型参数的方法,通过计算损失函数的梯度来最小化损失。简单来说,它是一种通过反复更新参数来逐步寻找使损失最小化的权重和偏置的最佳组合的方法。

Graph Convolutional Network

++Need to Fill++

Graph-cut

能量最小化算法在图像分割、去噪等与能量最小化相关的计算机视觉任务中得到广泛应用。能量最小化问题可以转化为在图中寻找最大流的问题,这被称为最大流最小割优化问题。 例如,将图中的每个节点视为像素,并假设边的权重表示像素之间的相似性,那么问题就是找到以最小成本进行割的方法。通过找到最佳的割方法,可以得到最佳的图像分割方法。

Graphical model

++Need to Fill++

Greedy Search

++Need to Fill++

Grid Search

网格搜索(Grid Search)是一种用于调整超参数(Hyperparameter)的技术,它可以找到最佳组合。它是一种蛮力算法的形式。 例如,如果想要找到最佳的正则化权重(Regularization weight)值,可以预先选择一些候选值(例如),然后尝试使用这些候选值进行训练,并选择在验证数据集上表现最好的超参数(例如0.3)。 缺点是由于是蛮力算法,随着需要调整的超参数数量增加,计算量会急剧增加。

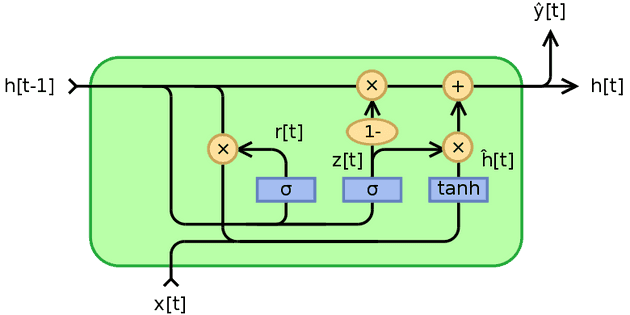

GRU(Gated Recurrent Unit)

在解决LSTM长期依赖问题的同时,减少了更新隐藏状态的计算量,从而提高了学习速度。 LSTM中有遗忘门、输入门、输出门,而GRU中只有更新门和重置门,没有输出门。更新门决定了之前的记忆要保留多少,重置门决定了如何将新的输入与之前的记忆组合。 换句话说,尽管GRU是LSTM的简化版本,但据说它们具有相似的性能。