A

June 03, 2023

本文旨在按字母顺序对团队研究过程中涉及的术语进行分类解释,为对该领域感兴趣的读者提供一份全面的术语表。

Ablation Study

消融研究(Ablation study)是指在构建模型或算法时,通过删除其中的不同组成要素(component),以了解其对性能(performance)的影响的方法。 从更加宽泛的定义来看,当我们希望确定所提出的要素对模型的影响时,我们会比较包含该要素和不包含该要素的模型。这在深度学习研究中具有非常重要的意义,因为它能够简单地揭示系统的因果关系(causality)。

Accuracy

准确率(Accuracy)是衡量分类模型性能的指标之一,当数据集包含两个或多个类别时,它表示正确分类的程度。 在二元分类(Binary Classification)中,准确率的定义更加明确。 它是从混淆矩阵(Confusion Matrix)中引入的概念,表示对整个数据集进行预测时,正确预测为真正例(True Positive, TP)和真负例(True Negative, TN)的数量。

Activation Function

输入值与权重相乘,加上偏置,并通过激活函数 Activation Function 进行处理,即激活函数的输出值为 。 传统上,使用 Sigmoid 或 Tanh 等激活函数较多,但最近更常使用的是 ReLU。 通过应用激活函数,神经网络可以逼近非线性函数。

Actor Critic

++Need to Fill++

AdaDelta

AdaDelta(自适应 Delta)与 AdaGrad 类似,可以根据时间来调整学习率(learning rate)。然而,AdaGrad 存在一个问题,即学习率下降得太快,在非凸环境中可能陷入局部最小值(local minimum)。 为了解决这个问题,提出了 AdaDelta 方法。 AdaDelta 不使用梯度的平方和,而是使用指数平均值。在这一点上,它类似于 RMSProp。然而,在更新参数的方式上,AdaDelta 使用了步长变化量(Delta)的平方根。

AdaGrad

AdaGrad(自适应梯度下降)是一种自适应的学习率变化算法,其特点是持续维持梯度的平方和随时间的变化。简单来说, 它通过逐渐减小学习率并计算速度来自适应地调整学习的更新强度。经常更新的参数被假设接近最优值,因此将步长(或学习率)调整为较小值;相反,如果参数远离最优值,则将步长调整为较大值,以便快速减小损失值。换句话说, 在更新参数时,较大移动的参数会被减少移动,而较小移动的参数会被增加移动,步长会自动调整。 由于这种特性,它被称为 “自适应”。然而,AdaGrad 存在一个问题,即随着训练的进行,步长变得太小,最终几乎不再移动。

Adam

Adam(自适应矩估计)是 RMSProp 和动量(Momentum)的结合。Adam 存储了迄今为止计算的梯度的指数平均,并且还存储了梯度平方值的指数平均。 可以简单地认为它是 RMSProp 的更稳定版本。在 Adam 的更新过程中,应用了偏差校正机制,用于弥补向量 m 和 v 在完全“热身”之前(迭代的前几步)被初始化为偏向 0 的问题。

Affine Layer

全连接层(Fully connected layer)在神经网络中也被称为密集连接层,意味着前一层的所有神经元与当前层的所有神经元相连接。 全连接层通常采用仿射层(Affine layer)的形式,其中输入表示前一层的输出,权重表示参数,偏置表示偏置向量(bias vector),激活函数表示非线性激活函数(non-linear activation function)。 受限玻尔兹曼机(Restricted Boltzmann Machine, RBM)是仿射层的一个例子。

Agent

在人工智能中,执行行为(action)的主体通常指的是在强化学习(Reinforcement Learning)环境中执行行为的实体。根据环境的不同,智能体(Agent)可以以各种形式实现。 例如,对于AlphaGo来说,智能体是执行围棋的人工智能,而对于Atari Breakout(打砖块)问题来说,智能体是一个左右移动并玩打砖块的人工智能。 在强化学习中,代理人是在给定环境中执行行为并获得奖励的实体。智能体观察当前状态,根据定义的策略(policy)选择行动,并从环境中获得反馈以最大化奖励。 这个过程是反复进行的,智能体通过经验学习选择最大化奖励的最佳行为选择方法。因此,在强化学习中,智能体是执行行为的主体,通过与环境的互动进行学习和决策。

AlexNet

AlexNet是一个基于卷积神经网络(CNN)结构的模型,它在2012年ImageNet Large Scale Visual Recognition Challenge(ILSVRC 2012)的图像识别领域取得了重大突破并夺冠,重新引起了对CNN的关注。

AlexNet的结构如下:

-

卷积层(5个):执行2D卷积操作,从输入图像中提取特征。这些层通过对输入数据进行过滤来生成特征图,同时保留图像的空间信息。

-

最大池化层:在给定区域中选择最大值,以减小空间分辨率并降低计算量。这有助于减小特征图的大小并保持抽象的特征。

-

全连接层(3个):每个神经元与前一层的所有神经元完全连接。这些层根据提取的特征对输入图像进行分类。

-

Softmax输出层:具有与总类数相对应的1000个输出,表示每个类别的概率。通过这个层,可以进行图像分类任务。

AlexNet通过深层结构和大型卷积滤波器尺寸,在图像识别领域取得了显著的性能提升,并对后续深度学习模型的设计产生了重大影响。

All-in-focus image

全焦点图像(All-in-focus image)是指图像中的所有物体都处于聚焦状态,呈现清晰的图像。要获得全焦点图像,需要使用多焦点图像融合技术,将具有不同景深(Depth-of-Field,DoF)的照片进行连接。

Attention Mechanism

注意力机制(Attention Mechanism)是自然语言处理领域首先提出的一个概念,通过集中学习特定区域,提高模型的预测准确性。 注意力机制被用作解决传统基于循环神经网络(RNN)的序列到序列(seq2seq)模型中两个问题(上下文向量信息损失和梯度消失)。其基本思想是在解码器每个时间步预测输出词时,再次参考整个输入句子的编码器表示。 然而,并非以相同比例参考整个输入句子,而是更加关注与当前预测词相关的输入词。注意力机制在计算机视觉领域也产生了影响,类似于人眼在观察物体时,只将该物体以高分辨率呈现,而将其他部分呈现为低分辨率。

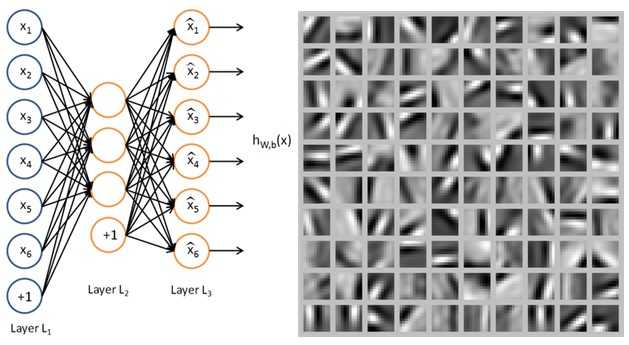

Autoencoder(AE)

输入和输出节点数相同的神经网络被称为自编码器(Autoencoder)。由于输入和输出节��点数相同,它被训练成学习恒等函数。 自编码器特别用于预训练算法中的维度缩减。通过反复进行前向传播和反向传播,自编码器学习使输出接近于输入(自我重建),并生成模型。在输入层和隐藏层之间发生信息压缩(编码),在隐藏层和输出层之间进行信息恢复(解码)。 由于隐藏层的节点数少于输出层的节点数,隐藏层必须压缩存储关于输入层的信息。因此,隐藏层被训练为存储关于输入层的代表性特征,并且权重也被优化。 因此,提取隐藏层的输出作为输入数据的压缩特征,可以应用于其他任务(例如,将自编码器隐藏层的输出作为分类器的输入,而不是原始输入)。

自编码器的架构和从隐藏层的输出中提取的特征(feature)

AutoML

++Need to Fill++

Autoregressive model

++Need to Fill++

Average Pooling

平均池化(Average Pooling)是卷积神经网络(Convolutional Neural Network, CNN)中用于图像识别的一种池化(Pooling)技术。 它在特征图层上使用滑动窗口(window sliding)的方式,计算每个窗口中所有值的平均值。这有助于将输入表示压缩为低维表示。